研究テーマ

研究の概要

概要

日本語や英語のような、人間の言語を機械が理解・処理するための技術を研究しています。

自然言語処理には様々なアプローチがありますが、私たちのグループでは、特許文や新聞記事などの大量のテキストデータから様々なルール・情報を自動獲得する、統計的手法を利用しています。

人間の知識の多くは人間の「言語」で記述されています。もし、機械が人間の言語を理解・処理できれば、機械が人間の知識の大部分にアクセス可能となり、人間の知的作業をサポート出来るようになります。

応用例

Web/Blog からの意見抽出、Web ページのコンテンツ特定、統計的機械翻訳、推薦システム(レコメンドエンジン)、次世代ウェブ検索エンジン、スニペット生成・自動要約、チャットボット(対話生成)、日本語スペルチェッカ、対訳辞書自動抽出、テキストマイニング、知識抽出

Web/Blog からの意見抽出 応用

Web や Blog 上のテキストから、人々の意見を自動的に抽出、整理する技術を研究しています。特に、意見をポジティブな意見か/ネガティブな意見かに分類する、評判分析と言われる応用に関する基盤技術の研究を行なっています。

まず、もっとも基本的な処理として、ポジティブ意見/ネガティブ意見を表す単語リストを自動的に生成する手法について研究しています。

- 良い, 優しい, ... :ポジティブ

- 悪い, 難しい, ... :ネガティブ

次の課題として、上記の単語リストに含まれない単語の中には、同じ単語であっても文脈によってポジティブ/ネガティブが変化するものがしばしばあります。私達は、文の構造や隠れた文脈を適切にモデル化することによって、より正確に意見を分類する手法について研究しています。

- 薄い:薄型テレビの文脈ではポジティブ/小説の文脈ではネガティブ

また、学生主体の開発型プロジェクトでは、これらの研究成果を応用し、BBS のコメントに自動的に表情アイコンを付与し、同時に機械翻訳も行う Google ガジェット「こめ寅」を開発しました。

- Kugatsu Sadamitsu, Satoshi Sekine, and Mikio Yamamoto. Sentiment analysis based on probabilistic models using inter-sentence information. Proceeding of the 6th edition of the Language Resources Evaluation Conference (LREC2008), 2008.

- 貞光九月, 福富祟博, 山本幹雄. トピック教師なしデータからのトピック依存評価表現モデルの獲得. 電子情報通信学会技術研究報告(NLC), Vol.107 No.480 pp.57-62, 2008.

- 貞光九月, 乘松潤矢, 福富崇博. 多言語横断Blog分析エンジンの開発. 筑波大学システム開発型研究プロジェクト2007年度研究成果報告, 2008.

- 貞光九月, 乘松潤矢, 福富崇博. Comment Transer:「こめ寅」~評判分析・機械翻訳技術のGoogle ガジェット上での実現~. 筑波大学システム開発型研究プロジェクト2007年度研究成果中間報告, 2007.

- 乾孝司, 奥村学. テキスト評価分析の技術とその応用. 情報処理, Vol.48, No.9, pp.995-1000, 2007.

- 高村大也, 乾孝司, 奥村学. スピンモデルによる単語の感情極性抽出. 情報処理学会論文誌, Vol.47, No.2, pp.627-637, 2006.

Web ページのコンテンツ特定 応用

近年のウェブページの増加は、CMS の普及に一因があります。CMS は、設定したページテンプレートに基づきウェブページを生成するため、誰でも簡単に大量のページを作成することができます。反面、各ウェブページにメニューや著作権表示が必ず付加されるようになり、ページに占める主要部分は縮小しています。

ページに占める主要部分が縮小していますが、ウェブページの検索システム、携帯電話向けのウェブページ変換システム、コンテンツフィルタリングシステム、また、研究へのウェブページ利用などは、ウェブページの主要部分を必要としています。

ウェブページから主要部分を特定する最も簡単な方法は、人手によりページ毎に正規表現で抽出ルールを作成する事です。しかし、無限にあるウェブページのルールを作成する事は、非常に困難であるため、人間がルールを準備せずとも主要部分を特定する方法を研究しています。

- 吉田光男, 乾孝司, 山本幹雄. CSSセレクタで表現されたコンテンツ抽出ルールの自動獲得. 楽天研究開発シンポジウム2009, pp.7-10, 2009.

- 吉田光男, 乾孝司, 山本幹雄. ブログ記事集合を用いたポストとコメントとの自動分離抽出手法の提案. 情報処理学会研究報告, Vol.2009-DBS-149, No.20, pp.1-8, 2009.

- 吉田光男, 山本幹雄. 教師情報を必要としないニュースページ群からのコンテンツ自動抽出. 日本データベース学会論文誌, Vol.8, No.1, pp.29-34, 2009.

統計的機械翻訳 応用

機械翻訳の研究が始まって約60年が経過していますが、人間の翻訳能力にはまだまだ到達していません。しかし、最近、研究レベルで一つのブレークスルーがあり劇的な性能向上が期待されています。それは、従来の人手で一つ一つ翻訳ルールをプログラムしていく方法とはまったく異なり、大規模な対訳例(100万文~1億文)から計算機が自動的に翻訳ルールを学習する手法です。利用できる言語データの爆発的増大(Webなど)と計算機パワーの飛躍的な向上によって最近になってやっと可能となってきました。

私たちのグループでは、300万文以上の英日対訳データや100億単語の言語データを用いながら、この先端技術を研究しています。具体的な研究テーマは以下の3つに分かれます。

- 統計的翻訳モデルの研究:より正しい翻訳に高い確率を付与できるモデルの研究

- 統計的言語モデルの研究:より言語として正しいものに高い確率を付与できるモデルの研究

- デコーダの研究:膨大な探索空間から正しい解をより正確・高速に探索する手法の研究

また、機械翻訳のウェブ応用として謎のニコニコ翻訳プロジェクト(徳永先生と共同研究)もありますので、ご興味のある方はぜひどうぞ。

推薦システム(レコメンドエンジン) 応用

アマゾンなどで使われている推薦エンジンを作成するには大きく2つのアプローチがあります。

1つはよく使われる、いわゆる「協調フィルタリング」と呼ばれる手法で他の似たユーザの利用・購入情報を利用して推薦する手法です。ただし、この手法は似たユーザがいない場合やまったく新しい対象を推薦することができません。これを補うものが、もう1つの「内容に基づくフィルタリング」と呼ばれている手法で、該当ユーザのこれまでの嗜好から似た内容の対象を探して推薦します。

この手法はまったく新しい対象に対しても適用できるが精度はあまり高くありません。本研究ではこの2つの手法を融合して推薦する統計的モデルを提案しています。例として、Wikipedia の編集履歴情報を利用して Wikipedia をガイドする(次に見るべき項目を推薦する)システムを想定し、このシステムで効果的に推薦できることを示しました。

(これは理論だけで、実際に Wikipedia をガイドするシステムは実現していません。どなたか我々の理論を実際に Wikipedia 上で動作させることに興味はないですか?)

- 内山将夫, 山本幹雄. Wikiのナビゲーション. 言語処理学会第12回年次大会発表論文集, pp.793-796, 2006.

- Masao Utiyama, and Mikio Yamamoto. Relevance feedback models for recommendation. Proceedings of the Conference on Empirical Methods in Natural Language Processing (EMNLP-2006), pp.449-456, 2006.

次世代ウェブ検索エンジン 応用

日本語に対する情報検索エンジンアルゴリズムに関する学術的なコンテストは、1999年のIREX(Information Retrieval and Extraction Exercise)が最初です。このとき、私たちのチーム(筑波大・豊橋技術科学大学・AT&Tベル研の混成)は Suffix Array を利用して、適応型の任意長 ngram マッチングを動的計画法で実現するという型破りなアルゴリズムで、参加大学中の最高性能をマークしました。

2005年度の卒業研究では、古典的なベクター・スペースモデルに代わる有望なモデルとして確率的な検索モデルを研究しました。数学的にやや難しいですが、数学的に簡単な高性能検索モデルなどありえないので、ここらへん野心のある学生はぜひどうぞ。

- 石原瑛美. ディリクレ分布を用いた言語モデルによる情報検索. 筑波大学第三学群情報学類卒業論文, 2006.

- 山本英子, 梅村恭司, 小沢智裕, 山本幹雄, Kenneth W.Church. 一般化文字列類似度を用いた文字ベースの情報検索. IREXワークショップ予稿集, pp.95-100, 1999.

- Tomohiro Ozawa, Mikio Yamamoto, Kyoji Umemura, and Kenneth W.Church. Japanese Word Segmentation Using Similarity Measure for IR. Proceedings of the first NTCIR workshop, pp.89-96, 1999.

日本語スペルチェッカ 応用

日本語ではかな漢字変換時の誤り(すなわち同音異表記の誤り)が多いです。上記の話題・文脈モデルを使って日本語のスペルチェック能力を高めることができます。

文脈を考慮しなくても「実行的な方法を実効する」の誤りを発見できますが、「その引き方はものすごい」の誤り(「弾き」もありえる)を発見することは困難です。後者の場合、広い文脈を見て話題が音楽であれば誤りであり、話題が運動会ならばおそらく正しいと考えられます。

誤り発見のための情報として、局所的にはマルコフモデル、大域的には文脈モデルを組み合わせたシステムを開発しました。

- 三品拓也, 貞光九月, 山本幹雄. 確率的LSAを用いた日本語同音異義語誤りの検出・訂正. 情報処理学会論文誌, Vol.45, No.9(20040915), pp.2168-2176, 2007.

Web/Blog を利用した情報抽出、知識獲得 基礎

Web や Blog には、上記の意見情報以外にも、さまざまな内容が書き込まれます。特に、日記風テキストと言われる Blog には、人々の日常生活情報が溢れており、このことに注目すると、人間がもつ常識的な知識をテキストから自動的に抽出することを通して、機械(ロボット)に知能を実装できるかも知れません。

知識獲得のケーススタディとして、私達は、イベントが起こる時間に関する知識を自動獲得する研究を行なっています。この研究によって、例えば、「花火」と言えば夜のイベントであり、「通勤」と言えば朝のイベントであることを機械が自動的に判定します。

また、2つのイベント間に因果関係があるかどうかを判定する数理モデルについての基礎研究を行なっています。この研究によって、例えば、「車が反対車線にはみ出すと、それによって交通事故が発生する危険がある」ことなどを機械が自動的に判定します。

- 野呂太一, 乾孝司, 高村大也, 奥村学. テキスト中のイベントの生起時間帯判定. 情報処理学会論文誌, Vol.48, No.10, pp.3405-3414, 2007.

- Takashi Inui, Hiroya Takamura, and Manabu Okumura. Latent Variable Models for Causal Knowledge Acquisition. The 8th International Conference on Intellignet Text Processing and Computational Linguistics (CICLing-2007), pp.85-96, 2007.

話題・文脈の確率モデル 基礎

文の意味は文脈や話題によって大きく変化します。そこで、文脈や話題を確率的に捕らえるモデルの研究が進められています。

この文脈処理技術の追求が、現時点における私たちのグループの理論的な面での中心テーマです。文脈処理技術は汎用的なので、様々な応用(機械翻訳, 音声認識, スペルチェッカ等)に適用可能で、その応用システムの性能を高めることができます。

具体的には例えば「混合ディリクレ分布」という確率分布を用いて、文書の話題をモデル化します。この理論によって、機械翻訳や音声認識で使われる基本技術の一つである「統計的言語モデル」の性能を飛躍的に上げることができます。

- 貞光九月, 三品拓也, 山本幹雄. 混合ディリクレ分布を用いたトピックに基づく言語モデル. 電子情報通信学会論文誌, Vol.J88-D-II, No.9(20050901), pp.1771-1779, 2005.

- 貞光九月, 山本幹雄, 内山将夫. 混合Polya分布による多項文書頻度のモデル化. 言語処理学会第10回年次大会発表論文集, pp.607-700, 2004.

- 山本幹雄, 貞光九月, 三品拓也. 混合ディレクレ分布を用いた文脈のモデル化と言語モデルへの応用. 情報処理学会研究報告, SLP, Vol.2003, No.104(20031017), pp.29-34, 2003.

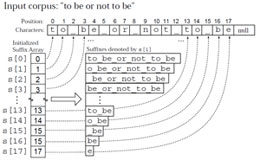

Suffix Array(接尾辞配列) 基礎

Suffix Array はテキストデータ中の全接尾辞(suffix)をソートしたものです。Suffix Tree でできるほとんどのことが比較的小さな空間(メモリ)でできるため、1991年の U.Manber & G.Meyers の発表以来、絶大なる人気を誇っています。

私たちのグループでは、AT&T と共同で、全テキストデータベース中の全部分文字列(データベースの大きさの二乗に比例する数の部分文字列が存在します)の tf(term frequency)と df(document frequency)を、Suffix Array を利用することで線形時間で計算するアルゴリズムを開発しました。二乗に比例する数の文字列が存在するのに、線形時間ですべての tf と df が計算できるのは不思議だと思いませんか?

このアルゴリズムを情報検索に応用したのが、本ページに記載している次世代ウェブ検索エンジンです。また、tf と df の計算は統計的な自然言語処理の基本技術としてよく使われるため、Suffix Array の自然言語処理応用の代表例として私たちの論文はよく引用されています(Google Scholar の引用文献検索)。

- Mikio Yamamoto, and Kenneth W.Church. Using suffix arrays to compute term frequency and document frequency for all substrings in a corpus. Computational Linguistics, Vol.27, No.1, pp1-30, 2001.